AIの安全性基準について、ASLをよく見かけるようになったが、もっと大きな話としては、EUのAI法(AI Act)がある。2024年5月21日に成立し、同年8月1日に発行した。

The AI Act sets out a clear set of risk-based rules for AI developers and deployers regarding specific uses of AI.

AI Act1

AI Actのサイトに書かれているリスクベースについての引用メモ

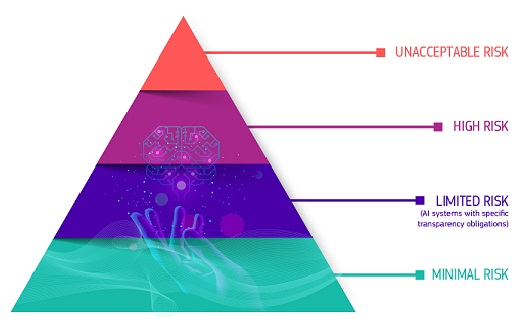

The AI Act defines 4 levels of risk for AI systems

| リスク | 概要 | 事例 |

|---|---|---|

| Unacceptable risk(許容できないリスク) | 人々の安全、生活基盤、権利に明確な脅威を及ぼすすべてのAIシステムは禁止 | AIによる操作や偽装、脆弱性の悪用など |

| High risk | 健康、安全、基本的人権に重大なリスクを及ぼすAIの活用は高リスクに分類 | 交通などのインフラにおけるAI活用は生命や健康の脅威となり得る。教育機関でのAI活用は個人の教育アクセスや進路の決定への影響し得る |

| Transparency risk(特定の特定の透明性リスク) | 透明性確保の必要に関連するリスク | チャットでは機会とやり取りしていることが認識できること、AIが生成したコンテンツであることが識別可能であること、など |

| Minimal or no risk | 最小限のリスクまたはリスクがないとみなされるもの。AI規則を導入しない | AIを活用したゲームやスパムフィルターなど |

このリスクベース基準に従うなら、シヴュラシステムは真っ黒である。一橋ビジネスレビュー72巻3号の寺田氏のコラムに、AI Act、過渡期の橋渡しとなるAIPact、DSAとDMAなとといった関連性がわかりやすくまとまっていた。

一方で、日本の強みも忘れてはならない。日本のAI戦略は、釈迦課題の解決を産業競争力の向上を両立させることをめざしており、この点はEUのアプローチよりも柔軟性があると言うことができる。

AI活用の推進とデジタル化(p88)

このために非常に多くの有識者が尽力されていることに感謝。